DeepSeek单周下载量约240万次及其模型特性引发关注

DeepSeek的每周下载量约为240万次,这可能超过了上一年春节期间通过广告所获得的下载;

触发了美国股票的原因是DeepSeek-V3和DeepSeek-R1的两种模型,前者是4O型号,后者是O1型号。

DeepSeek-V3培训成本仅占LLAMA 3的1%,而DeepSeek-R1推理成本仅占OpenAI O1的3%;

DeepSeek-V3的大量创新与克服使用H800所带来的记忆和带宽不足有关(而不是H100);

R1系列模型放弃了RLHF的HF(人类反馈)部分,仅留下纯RL(增强学习)。在此过程中,出现了“反射”模型。

DeepSeek还使用其800,000个思维链数据来罚款Ali的QWEN模型。结果,后者的推理能力也提高了。

DeepSeek尚未推出大型的金融投资模式,但这只是时间问题。

在1月27日清晨,DeepSeek赶到了中国Apple App Store和美国地区的免费列表中的第一个下载卷,超过了原始列表的原始列表,这也是国内申请首次拥有的原始列表取得了这一成就。半个月前(1月11日),DeepSeek的应用程序刚刚推出了iOS和Android应用程序市场。

那天晚些时候,DeepSeek应用程序开始出现。该公司声称其服务已受到大规模恶意攻击的攻击,因此它将暂时限制新的用户注册。当晚开业的美国技术股票集体下跌 - 费城半导体指数(SOX)下跌了9.2%,是2020年3月以来最大的下降。其中,NVIDIA的股价接近17%,市场价值蒸发近6000亿美元这是美国股票历史上最大的。此外,Broadcom,TSMC,ASML,Google和Microsoft也分别下降了17.4%,13%,7%,4%和2.14%。即使是WTI原油磁盘也曾经下降了3%,因为一些交易者认为,如果大型模型的培训和推理不再需要这么多的计算能力,那么数据中心的功率需求将减少。来发电。

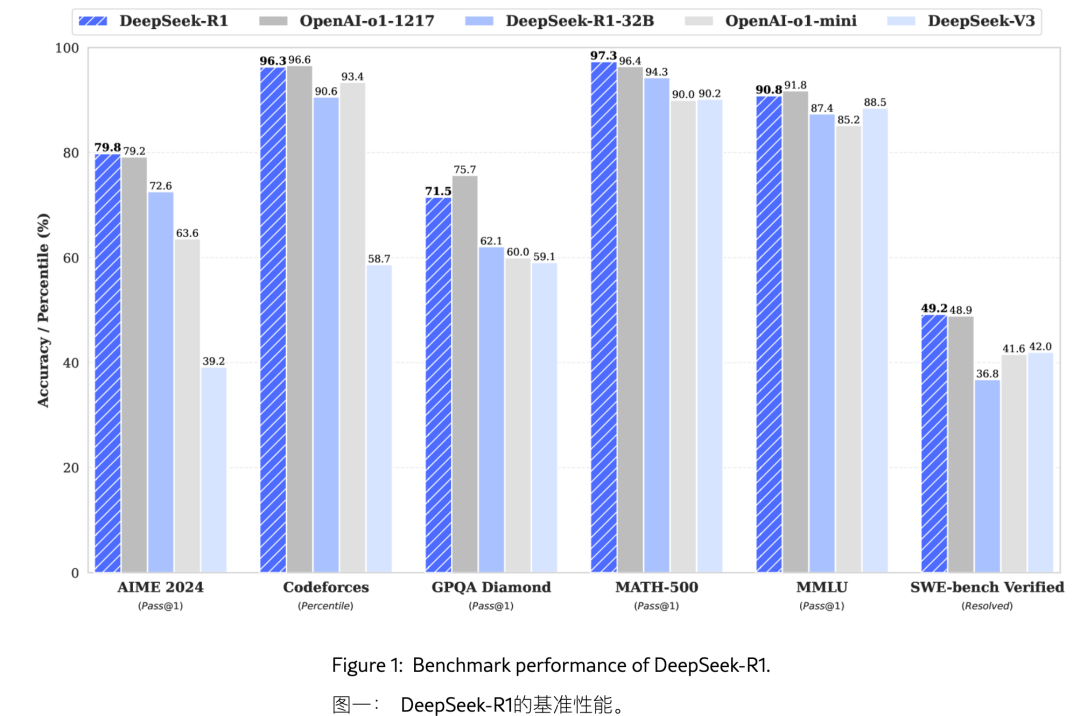

DeepSeek声称DeepSeek-R1模型将OpenAi O1绑在各种功能中。

DeepSeek是一家在杭州的大型模特公司,成立于2023年。在-2024年中期,该公司在市场上并没有引起太多关注。但是在2024年的最后一个月,它发行了多种模型。其中,圣诞节后出版了名为DeepSeek-V3(以下称为“ V3”)的模型声称,“等效”行业领先封闭的封闭源模型GPT-4O和Claude-Sonnet,这与“等同于”,这是一个很好的开放式。源模型Meta的Llama 3,总培训成本仅为557.6万美元,该数字仅占前者的1%(估计投资超过5亿美元);一个称为deepSeek-r1的模型(以下简称为“ R1”)。同样,DeepSeek声称R1模型“在一系列任务中实现了与OpenAI O1相同的性能”。

1月29日,彭博社引用了未透露姓名的人的要求,他们报告说,微软的安全研究人员发现,DeepSeek的员工使用Openai API偷走了2024年秋天的大量数据。V3或R1型号。但是,OpenAI明确规定,其他公司不允许其他公司使用其模型生成的数据培训模型。在-2023年中期,由于行为类似,Byte Beating因Openai有摩擦。 DeepSeek尚未回答这一话。

麻烦不仅如此。同一天,意大利当局要求DeepSeek提供有关公司如何处理用户数据的信息。 DeepSeek将有20天的时间准备回答。目前,DeepSeek已从意大利的Apple和Google的应用商店中删除。

外界对DeepSeek仍然有很多疑问。例如,它的模型是否只是美国高级模型的蒸馏模型,它的创新是否真的很重要,以及美国技术库存是否有过度反应。这些问题实际上在技术报告中得到了回答。

1。如何形成由DeepSeek引起的全球技术圈?

1月27日的市场冲击比DeepSeek在模型论文中发布的惊人数据晚了一个月。直到一周前2025年的达沃斯论坛,尽管许多人谈论了DeepSeek,但这些意见大多是保守的或充满疑问的。例如,DeepMind首席执行官Demis Hassabis在达沃斯(Davos)声称DeepSeek模型确实是一个“意外”,但他说:“ DeepSeek模型的工作原理不确定,包括它取决于其他美国公司的结果。模型的模型。

除了怀疑“ V3是美国的切割模型的蒸馏模型”之外,DeepSeek结果声音的另一种声音代表了Scale AI的首席执行官Alexandr Wang。在接受CNBC的采访时,他声称DeepSeek拥有50,000名NVIDIA最先进的AI芯片H100,这意味着在获得模型突破之前,DeepSeek违反了美国的筹码禁运政策。由于芯片控制,从2022年秋天开始,NVIDIA不再向中国市场提供最高的AI芯片H100。替换产品为H800,在内存和带宽方面更具限制 - 性能仅为H100的一半。

但是,与此同时,Meta员工在匿名网站上表示,DeepSeek只能以仅1%的投资超过Llama 3的性能,这使Llama 4的投资预计将比Llama 3贵几倍。技术媒体。该信息立即报告说,META建立了4个专业研究团队,以研究DeepSeek的工作原理,并基于此改善Llama。在发行V3之前,Llama是世界上最强大的开源模型,直到发行后V3更换为止。

如果只有V3效率,那么DeepSeek可能不会引起足够的关注。 1月20日发布的R1模型为DeepSeek的热量增添了重要的火灾 - 这是一个类似O1的推理模型,并且可以在应用程序中立即体验。其他聊天机器人(例如ChatGpt)之间的区别在于,当DeepSeek的聊天机器人的同名响应用户问题时,它将完全显示思想链(COT)。 “内在活动”舒适了出口或模糊表达的情绪,激发了许多用户的热情。业务的本质是造成稀缺。无论在人类成员和AI成员中,他们的同理心都是稀缺的。

当他说话时,DeepSeek更加“人类”。

COT是所有O1模型正在发展的能力,人类几乎是如此合理。但是,这种思维过程也是人工智能公司希望保密的重要数据资产。如果您询问它在Chatgpt中在想什么,几次,Openai可能会发送电子邮件警告您撤销您的帐户。

马克·安德森(Marc Andreessen)的风险投资机构Andreessen Horowitz(A16Z)的创始人将R1描述为“人工智能时刻”。 Sputnik是苏联于1957年发起的第一个人工卫星。其他人说,DeepSeek系列模型的发布是美国AI行业中的“珍珠港事件”。这意味着,作为全球人工智能领域的技术高地,美国正在失去其AI商业模式和技术护城河。

2. DeepSeek-V3取得了什么突破?

DeepSeek的突破来自两个层次:低成本和推理能力。其中,V3的突破主要是培训成本和计算效率。 R1为培训和推理模型开辟了新的途径。

具体而言,V3采用了比传统的Moe(专家模型)体系结构更好的DeepSeekmoe架构,而DeepSeekmla比传统的多头注意(MHA)更好。

DeepSeekmoe

传统的密集模型(例如GPT-3.5)在培训和推理过程中激活了所有参数。但是,实际上,并非模型的每个部分对于当前任务都是必需的。因此,MOE的概念是将模型分为多个“专家”,仅在推理过程中激活必要的专家。 GPT-4也是MOE模型。据说有超过1.67万亿的参数,其中大多数分布在16个专家模块中(例如FFN层)。 ,因此大大减少了计算量。 DeepSeek的V3具有6710亿个参数,其中活跃专家的总参数为370亿。

DeepSeek在V3模型论文中说,与传统的Moe相比,DeepSeekmoe使用“更精细的粒度”专家来使专家更加专业。单个专家只有数十亿个参数可以提高任务适应性。同时,DeepSeekmoe将以“共享专家”的形式隔离一些专家,以减少专家之间的冗余,因此V3模型更好地激活相同数量的专家和参数。

DeepSeekmla

多头注意(MHA)是生成AI计算的核心机制。它允许模型同时关注用户输入的不同级别,并并行处理这些不同的维度,并将其集成以完成响应。本质此并行处理过程类似于图像处理中的并行计算,因此图形处理中使用的GPU(图形处理单元)已成为AI计算的理想硬件平台。

但是,此过程将发生在大量缓存中,这限制了推理的效率。 DeepSeekmla发现了一种结合缓存数据压缩的方法,该方法大大降低了推理过程中的内存使用并确保有效的推理。 DeepSeek在论文中说,由于这些创新,其V2模型(上一代V3模型)在单个节点中获得了每秒超过50,000个令牌的吞吐量。第一代模型的最大吞吐量生成了5.76次。

MTP(多语预测,更多的代币预测)

当传统的大型模型满足用户的需求时,只有预测下一个令牌,而V3可以通过MTP技术预测接下来的两个令牌。这里的关键是代币准确性的第二个预测(即“接受率”,可以最终采用预测令牌)。 DeepSeek评估说,在不同的主题中,该模型产生的第二个令牌接受率达到85%至90%。这种高接受率意味着V3可以以传统单代币预测模式的两倍的速度生成文本。

FP8:低廉的培训

FP8表示8位浮点。数量越高,计算精度越高,但是计算速度将同时降低。 DeepSeek使用FP8数据格式来训练V3,并在模型计算的不同链接(即混合精度框架)中实现了不同链接中数据的灵活性和交替使用数据。在参数通信的过程中,DeepSeek也达到了FP8的精度。通过此过程,DeepSeek实现了加速的训练并减少了GPU记忆的使用,以及“首次在大型模型上FP8混合精度训练框架的有效性”。

DeepSeekmoe + DeepSeekmla架构早在DeepSeek的V2模型开发就开始开发。 V2模型验证了这种组合是否可以考虑维持绩效的前提下的有效培训和推理。 V3在此基础上进行了许多改进。这是另一种创新 - 自我奖励,它确实允许V3模型超过七野3的功能。

后传输:自我奖励

经过不到两个月的预培训并花费了26.64亿个GPU小时,DeepSeek使用55,000 GPU小时进行了“自我奖励”和蒸馏后进行V3培训。

加强学习的典型情况是alphago。通过为模型提供GO规则,并告诉它如何赢得游戏,该模型将找到满足所有目标的途径。但是,这种机器学习方法中最大的问题是如何设置奖励功能。在具有很高推理能力(例如数学,编程,GO等)的领域可用。通常有明确的答案,边界很明显。在OpenAI的O1模型之后,外界对奖励功能设定了增强学习过程的奖励功能充满好奇心。在OpenAI不再开放之后,DeepSeek展示了它如何为V3模型设置奖励功能 - 直接将V3模型本身用作奖励生成模型,并决定是否奖励自己。

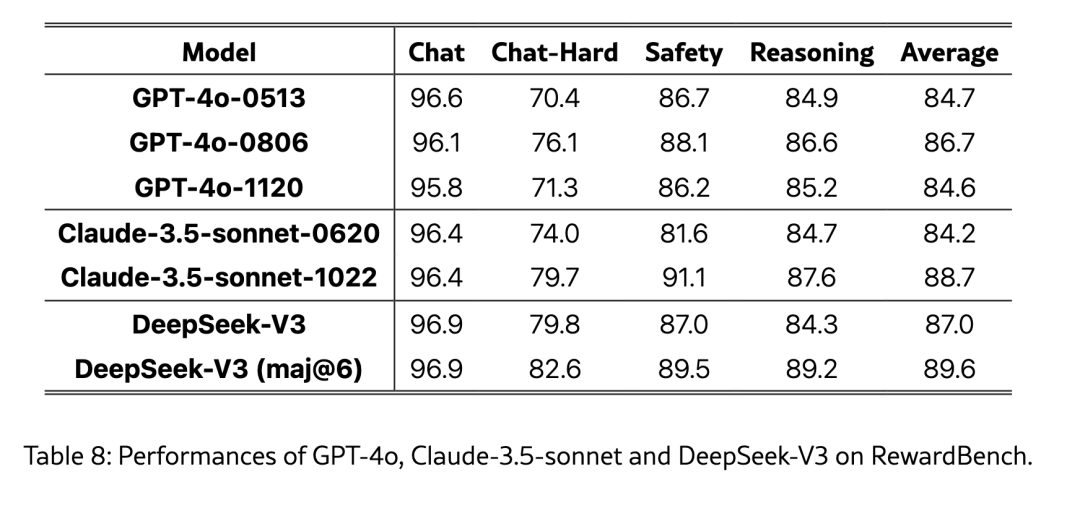

DeepSeek将V3的判断力与GPT-4 O和Claude-3.5的判断能力进行了比较,称V3的性能等于GPT-4O-0806的最佳版本和Claude-3.5-Sonnet-1022,以及V3的判断能力也可以通过投票技术来增强。因此,DeepSeek使用对V3和多次投票的评估作为“奖励函数”,为开放问题提供自我奖励。

DeepSeek认为,判断力本身的基本模型是一个足够好的奖励模型。

“ LLM(大语言模型)本身是一个多功能处理器,可以将非结构性信息从不同的场景转化为奖励,并最终促进LLM的自我改善。” DeepSeek在V3模型上发表的论文中说,这意味着如果大型模型足够好并且判断力,那么它应该足以评估像优秀人类这样的AI答案。此过程是LLAAA 3之外的V3模型的关键。

3。为什么DeepSeek达到了低成本,其他制造商,尤其是美国制造商,没有这样做?

目前,“资源诅咒”一词不合适。与中国制造商相比,美国大型模型公司为其大型型号开发道路有很多现金和计算能力。 NVIDIA还在不断地发射更强大的计算能力和更昂贵的芯片,以满足这些大型制造商的需求。大型模型的扩展定律长期以来从模型本身扩展到资本链接。许多大型模型制造商 - 不仅是国内,他们都因为去年下半年昂贵的昂贵而退出了游戏。

对于拥有丰富资源的大型工厂,阻力最小的方法是招募,高薪并向Nivine支付高费用。 DeepSeek-V系列的几乎所有创新都与适应带宽限制的H800芯片有关。

4。DeepSeek-V3是蒸馏模型吗?

宣布V3的培训成本后,最大的问题是它可能是与其他高级模型提取的模型。

在V3和R1模型的相关论文中,DeepSeek最终强调了对蒸馏技术的探索。例如,在V3模型中,DeepSeek使用从DeepSeek-R1系列Model-R1中提取的推理能力作为教师模型生成800,000个用于培训的培训样本。 “从DeepSeek R1系列模型中提取推理COT(思维链),并将其纳入标准LLM(大型语言模型),尤其是DeepSeek-V3。我们的装配线已优雅地整合了R1的验证和反射模式与DeepSeek-- V3在中间,其推理性能得到了显着改善。

除了使用从R1系列模型中提取的800个MESI链样品训练V3外,DeepSeek还进一步探讨了将这些数据应用于阿里巴巴的QWEN2.5系列模型的效果。 DeepSeek在论文中说,QWEN系列模型(DeepSeek-R1-Distill-7B和DeepSeek-R1-Distill-Qwen-32b的DeepSeek-R1-Distill-Distill-Distill-Distill-Distill-Distill-7b-32b)比以前的版本更好。 “我们已经证明,可以将较大模型的合理模型提取到较小的模型中。” DeepSeek说,这为大型模型的“培训”优化提供了一个有希望的新方向。

但是,这些尝试并不意味着DeepSeek的低成本V3本身就是一个蒸馏模型。根据其论文,V3的上一代Model V2使用了8.1万亿代币数据培训,V3模型的预培训数据扩大到14.8万亿。该论文表明,V3使用约280万小时(包括266.4万小时预训练,119,000小时的上下文长度培训和培训后55,000小时),并且完成了约39.7亿次浮动点操作。该计算量与14.8万亿代币的数据集的理论需求一致。换句话说,根据DeepSeek的DeepSeekmoe+DeepSeekmla体系结构,使用FP8的低精确培训和传输数据,并且一次预测多个令牌,DeepSeek的确可以达到不到600万美元。这是一个合理的数字。

5。与DeepSeek-V3相比,DeepSeek-R1的进展在哪里?

V3模型和R1系列模型是基于基于V3的V3基础的基本版本开发的。与V3(4O类)模型相比,R1(O1)系列模型进行了更多的自我评估和基于自我奖励的强化学习作为后培训。

在进行R1之前,该行业的大型模型通常取决于RLHF(根据人类反馈加强强化学习)。这种增强的学习模型使用人类写的大量高质量的问答来理解“什么是一个好答案”,并帮助模型在奖励方面有所回报。知道如何在没有明确情况的情况下做出艰难的选择。 GPT-3的使用使GPT-3演变成更人性化的GPT-3.5,在2022年底推出Chatgpt时创造了令人惊讶的体验。但是,GPT不再进步也意味着该模型已经达到了瓶颈。

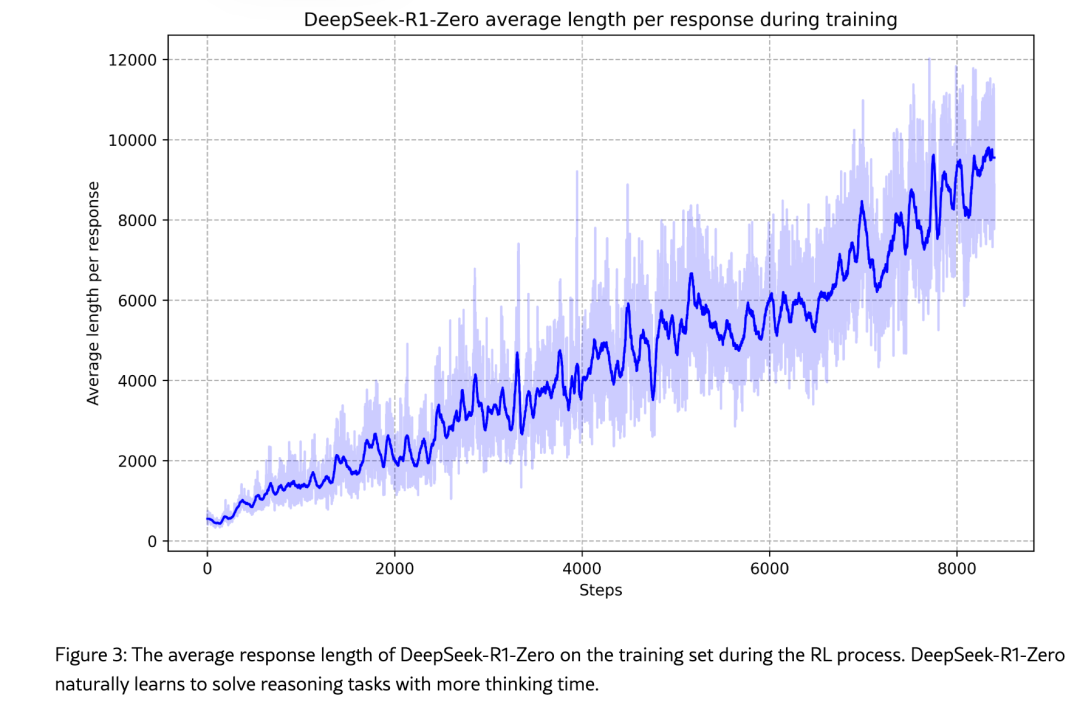

R1系列模型放弃了RLHF中的HF(人类反馈,人为反馈),仅留下纯RL(增强的学习)。在其第一代版本的R1-Zero中,DeepSeek非常彻底地启动了以下增强学习过程:为模型设置两个奖励功能,一个用于奖励“正确的结果”(外部工具验证的最终正确性答案),另一个回答“正确的思考过程”(小验证模型推理和推理步骤的逻辑连贯性);鼓励模型一次尝试几个不同的答案,然后根据两个奖励功能进行评分。

DeepSeek说,R系列模型在加强学习方面已成为“反思”。

DeepSeek发现,R1-Zero产生的答案增强了学习过程的阅读不佳,并且该语言通常与中文和英语混合在一起,但是随着培训时间的增加,R1-Zero继续“自我进化”和开始出现“反思”的复杂行为,例如“解决问题的替代方法。这些行为尚未被明确编程。

DeepSeek说,这个“ AH时间”出现在模型培训的中间。在此阶段,DeepSeek-R1-Zero通过重新评估其初始方法来学习更多的思维时间。 “目前,它显示了加强学习的力量和美,只要提供了正确的激励措施,该模型将独立制定高级问题的策略。” DeepSeek说,经过数千个“纯粹的增强学习”步骤,DeepSeek-R1-基准测试中零的性能与OpenAI-O1-0912的性能相匹配。

DeepSeek在论文中说:“这是第一个验证LLMS的推理能力可以通过RL(增强学习)激励的,而无需SFT(有监督的微调)开放研究。”

但是,由于模型模型在培训和培训中的过度重点,答案的正确性是语言流利度的基本能力,这导致了中文和英语的产生。为此,DeepSeek添加了一个新的冷启动,其中数千种链式思维(COT)数据可以微调V3基本模型。这些数据包括规范性语言表达和多步推理示例,因此该模型最初掌握了逻辑和连贯的逻辑。产生能力;然后开始增强的学习过程,该过程生成了大约600,000个与推理相关的样本,约有200,000个样本与推理无关。将这些800,000个样品数据再次用于微调V3碱基后,将获得R1。 ———前面提到的IM,DeepSeek还基于基于数据的数据,具有数据的良好态度的Alibaba的QWEN系列开源模型,结果表明其推论能力也有所提高。

6. DeepSeek是否完全解决了推理问题?这是否意味着AGI不需要新的范式?

DeepSeek在V3模型上的创新都是工程学。其突破的更大意义是,大型模型的现有业务模型和美国在中国的筹码制裁 - V3的大量创新以及使用H800而不是H100而不是H100而不是H100而不是H100带宽带来的带宽无关。为此,DeepSeek甚至绕过了NVIDIA的编程工具CUDA,并重新编程了每个H800芯片上的132个处理单元中的20个,以管理交叉芯片通信。

相比之下,纯强大学习中R1的探索至少达到了与OpenAI O1相同的水平。 O1背后的技术是否与目前未知的R1相同。 Openai尚未透露其O1模型的增强学习解决方案。不同的大型模型公司在增强学习方面的设置奖励功能方面总是非常不同。

但是,不能说R1已经完全解决了推理问题。至少只要基于O1的操作AI - 载体无法像人类那样操作各种电子设备,就不能说这种AI水平是通用人工智能。目前,操作员理论上可以根据用户的要求执行鼠标和键盘允许的所有操作:只要用户口头删除它,它就可以帮助用户订购外卖或找到旅游路线;在遇到问题或错误时,它可以使用增强的学习带。推理能力通过自我纠正来纠正;当真正不可能解决问题时,它将将控件的控制归还给用户 - 就像自动驾驶一样,当AI遇到决策困难时,AI会将方向盘返回到人类驾驶员。像自动驾驶一样,这种“接管率”将是AI是否基于强化学习的指标之一。

7. DeepSeek的结果将如何影响AI行业的未来?

1月27日,美国技术股票的性能最初显示了DeepSeek在市场上发布的几种模型的影响力和范围。

在DeepSeek低成本模型时,美国总统特朗普刚刚宣布了一个AI基础设施项目,总金额为5000亿美元,OpenAI和Softbank承诺将参加。此前,微软曾表示,它将在2025年将800亿美元投资于AI基础设施,而Meta的Zuckerberg计划在2025年投资600亿至650亿美元,以便为其人工智能策略投资。DeepSeek的低成本模型使人们怀疑人们怀疑人们这些惊人的投资是否浪费了投资。如果只有数百万美元,而不是数亿元人民币,则可以训练4o级别的模型。它可能只有1/10甚至1/100。

Nvidia的股价最多,但从长远来看,最大的影响不一定是NVIDIA。相反,将是其他基于模型开发业务模型的公司。跳跃等属于此范围。在推理成本方面,OpenAI O1获得了15美元和60万美元的投入和百万美元的产出,而DeepSeek R1也只有0.55美元和2.19美元的投入和输出价格,几乎占以前的3%。早些时候,Openai向使用最先进的O1的用户收取了每月200美元的订阅费,他们仍处于损失状态并计划提高价格。 DeepSeek R1的出现可能会使Chatgpt的价格上涨计划。

此外,许多中国模型公司(例如Byte Beating和Moon's Dark Side 2024)可能会漂移用于用户增长的广告成本。数据监视公司传感器塔数据显示,自今年1月11日推出以来,DeepSeek应用程序的累积下载超过了300万次,其中80%的下载集中在1月20日至1月26日。里面。如果保持了这种增长率,DeepSeek将很快进入AI应用训练营,数千万用户。

在股价下降近17%之后,NVIDIA在一份声明中指出,DeepSeek的结果证明市场对Nvidia芯片的需求将更多(不少于)。这一说法是有道理的,因为当模型培训和推理变得更便宜时,他们只需要消耗更少的计算能力,而人工智能的商业化可以更快地进展。例如,R1的小型版本可以在普通的家用计算机上运行,这将有助于促进AI应用程序的普及和民主化 - 苹果等公司为大型模型提供终端设备,将是赢家。在1月27日美国技术股票的急剧下降期间,苹果也是仅有的两家尚未跌倒的技术公司。另一个是亚马逊,它具有云计算业务。云计算业务需求。

与培训课程相比,商业化后的推理链接将消耗更多的计算能力。此外,更有效的计算并不意味着更多的计算能力是没有用的。但是,在短期内,NVIDIA订购的技术公司将变得更加谨慎。

当然,最大的赢家是消费者。

8。为什么要投资人工智能的幻想食谱 - 一家定量投资公司?

DeepSeek由Liang Wenfeng于2023年12月创立。在此之前,他在2015年建立了一个名为“高级飞行”的定量对冲基金,该基金通过AI分析了财务数据以做出交易决策。在2019年,幻想量化成为第一个在中国筹集超过1000亿元人民币的定量对冲基金。

尽管有一个声音说金融市场与天气不可预测的不可预测是不可预测的,但这些人可能是正确的,但是自1980年代以来,数学家和计算机科学家一直希望为价格建模并相应地赚钱。从1988年到2018年的30年中,美国定量投资巨头文艺复兴技术创造了39.1%的年化复合收益率,远远超过了依靠巴菲特和索罗斯决定何时下注的投资大师。

这些量化基金并不是下一刻都追求金融市场的价格,而是专注于在市场中找到特定的价格模型。例如,“ 24小时效应”模式:星期一的价格变化通常是周五趋势的延续,这种趋势将在星期二逆转(24小时效应);趋势,然后在周五关闭之前购买下一个星期一早上出售它,并且很可能会赚钱。例如,一旦一些资产欣赏第一天,它将继续欣赏第二天,反之亦然。这些预测性财务信号已成为定量基金用于指导投资的交易因素(指标)。尽管潜在的利润空间并不大,但只要交易频率足够高(与价值投资相反),定量基金就可以吃市场的脂肪尾巴。

大型模型擅长从大型数据中查找模型。这种能力正面临着渴望从财务数据中找到交易因素的量化基金的需求。幻想的量化也不例外。 DeepSeek尚未启动相应的金融投资模型,但这只是时间问题。

发表评论

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。