英特尔新品瞄准推理市场,国内数据中心将步入新阶段

“也许中短期内,市场的焦点会集中在一些大规模的通用模型上。但对于AI来说,更广阔的应用空间其实是在推理场景。”近日召开的英特尔®至强®6性能发布会在酷睿处理器发布会结束后,英特尔市场集团副总裁、中国区云与行业解决方案及数据中心销售总经理梁亚丽在接受《财经》记者采访时表示:金融美联社。

据中国财经联合会记者多方采访显示,目前国内大型模型厂商至少70%的算力成本仍然用于训练,未来推理将成为“人工智能的下半场”。大型模型。”国内外不少厂商都将目光投向了推理算力这块蛋糕。芯片巨头英特尔的服务器CPU Xeon系列重量级新品也瞄准了推理市场需求,直接带动了今年9月至明年第一季度多家服务器厂商的新品上市。随着市场的密集投放,国内数据中心有望进入新的发展阶段。

推理算力的需求可能是训练的10倍,供给侧紧盯这块蛋糕。

“事实上,在AI技术的实际应用过程中,最直观、最强烈的用户体验往往就是推理环节的表现。虽然我们过去一直在强调大模型训练的重要性,但当涉及到企业时,应用层面,推理的需求规模往往是训练需求的5-10倍。”从推理算力的需求来看,紫光旗下新华三集团计算存储产品线副总裁刘洪成表示。集团(000938.SZ)人士告诉中国财经报记者。

他进一步告诉财联社记者,通用模型应用于具体行业时,往往需要结合企业数据进行私有化微调和推理。 “通用大模型的投入成本太高,很多企业都无法承受,而且投入与产出的时间比也较长。因此,企业更倾向于对通用模型进行微调,以满足自身的具体需求和需求。”采用推理来实施应用。”

财联社记者采访了解到,不少从业者认为算力需求将持续增长,看好行业发展前景。

“我们认为,能够在‘百款之战’中幸存下来的通用大型车型数量将非常有限,可能不会超过一只手可以数的数量。一些玩家可能会面临巨大的挑战或甚至被淘汰出市场,但从整个市场来看,训练规模的需求还是很大的。货币化后,我们预计将会有一个规模达到训练市场的规模等待着我们,预计未来5-10年算力投资将保持快速增长。”刘洪成说道。

从供给来看,据财联社记者观察,国内热门的华为、GPU独角兽绥远科技、必仁科技因近期IPO而备受关注,海外AMD、Cerebras Systems、FuriosaAI和其他多家芯片厂商也加大了AI推理竞争。与此同时,Meta、微软、OpenAI等厂商也透露了自行开发推理芯片的计划。 Meta已于今年上半年正式发布MTIA v2芯片。

美联社记者询问英特尔如何看待推理算力供给侧的蓬勃发展趋势。梁亚莉表示,前述厂商自行研发推理芯片,“一方面是因为需求旺盛,另一方面是为了在价值和性能之间找到平衡点。 ”

她认为,在推理算力需求下,硬件架构和性能固然重要,但更重要的是软件优化和系统整体设计。比如在软件层面,深度学习框架需要不断优化;在整体系统设计层面,无论CPU、GPU甚至FPGA,最重要的是如何与行业每一个具体场景深度融合。

CPU可进行10B模型推理,驱动服务器创新

英特尔最新至强6性能核心处理器(代号Granite Rapids)的发布,在AI推理算力赛道上迎来了更加强大的CPU玩家。

据悉,至强6性能核心采用分离式模块化设计,包括Intel 3进程计算模块和Intel 7进程I/O模块;它配备了多达128个X86核心,支持DDR5内存高达每秒6400MT和每秒8800MT。 MRDIMM 内存、6 个 UPI 2.0 链路(速率高达每秒 24 GT)、96 个 PCIe 5.0 或 64 个 CXL 2.0 通道、504MB L3 缓存。

Intel Xeon 6能效核心处理器(代号Sierra Forest)于今年6月推出,针对高核心密度和规模扩展所需的高性能任务进行了优化,而性能核心处理器则针对计算密集型和AI工作负载。针对所需的高性能进行了优化。

公开资料显示,Xeon是Intel为了区别于普通个人电脑市场而开发推出的服务器CPU品牌。该产品线针对中高端企业服务器和工作站市场。英特尔数据中心与人工智能集团副总裁、中国区总经理陈宝利透露,现有AI服务器中的头部CPU大部分仍是英特尔CPU。基于Intel“四年五制程节点”战略,2024年至强6系列将采用Intel 3代制程技术。

据悉,从第四代至强开始,英特尔推出了用于AI加速的专用指令集“英特尔®高级矩阵扩展(以下简称AMX)”,让CPU能够支持市面上常见大型模型的推理计算。第四代和第五代Xeon可用于处理6B、7B甚至13B型号,正在业界广泛使用。在第六代Xeon中,AMX也得到了升级。

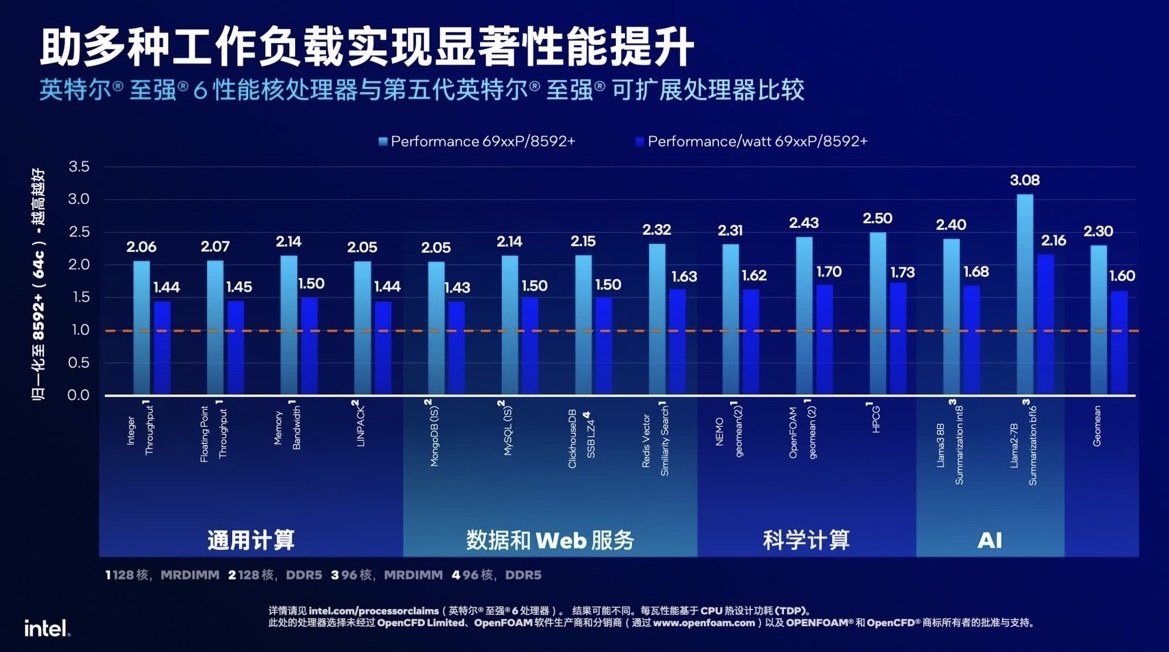

财联社记者在发布会上了解到,从实际推理性能来看,对于70亿参数的Llama2大模型推理,至强6性能核心的性能和每瓦性能比第五代至强提升了3.08倍。单CPU。 ,提高2.16倍;对于具有 80 亿个参数的 Llama3,分别有 2.40 倍和 1.68 倍的提升。

(受访者供图)

“两年前,主流服务器搭载的至强处理器应该有24-48核,与上一代相比,至强6性能核心性能装备从64核增加到128核,单核性能提升1.2次”。陈宝利在发布会上说道。

据财联社记者观察,除了CPU核心数和整体性能的提升外,在GPU用于AI推理并被视为主流的当下,这款CPU用于附加推理的意义在于推动国内数据中心进入新的发展阶段。

刘洪成认为,一体化架构比单一GPU服务器更符合企业私有化微调和推理的需求。 “因为对于私有领域的小规模训练和推理任务,融合架构的投资回报率更高,并且可以更高效地利用资源。”

梁亚丽也对财联社记者表示,“未来的市场环境下,性能和成本一定要平衡。尤其是推理场景,只追求性能是不合适的。企业最终要平衡的是在这些方面所花费的成本。”计算能力的成本是多少?它如何转化为企业的商业价值?最终每个人都需要进行成本效益分析。”

财联社记者注意到,由于生成式AI算力需求持续增长,在2024腾讯全球数字生态大会和2024云栖大会上,两大互联网巨头的“主场”本月引起业界关注,围绕Intel Xeon 6性能核心的讨论逐渐增多。

而对于OEM厂商来说,超融合服务器产品总经理朱勇对财联社等媒体表示,基于通用场景的CPU推理可以实现“一核多用”:“现在CPU已经发展到了这样的地步:在大型模型推理场景中,它可以完成大约100亿次任务,这给客户带来的好处是可以降低TCO。”

“过去我们经常区分通用服务器和GPU服务器,但在这一代至强6服务器上,我们实现了融合的基础设施,可以同时兼顾通用计算和GPU加速需求。这种融合将加速各行业对新技术的需求,在技术应用的推动下,用户不再需要在不同类型的服务器之间进行选择,而是可以更灵活地应对多样化的计算需求。”刘洪成说道。

此外,财联新闻记者获悉,浪潮信息(000977.SZ)、超融合、新华三、中兴通讯(000063.SZ)、联想等厂商基于Intel Xeon 6性能核心处理器的服务器新品将推出一款又一个。

发表评论

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。