OpenAI 面临高质量数据不足困境,AI 模型改进速度或放缓

一些测试过Orion的OpenAI员工发现,虽然Orion的性能超过了OpenAI现有的所有模型,但其性能质量的提升远小于从GPT-3到GPT-4的飞跃。这意味着随着高质量数据变得有限,人工智能模型的改进可能会放缓。

不仅如此,Orion的训练涉及AI从旧模型(例如GPT-4和一些推理模型)生成的数据,这可能会导致它重现旧模型的一些行为。

为此,OpenAI 成立了一个“基础”团队来研究新方法,以便在高质量新数据供应减少的情况下保持 AI 模型的改进。据悉,该公司计划基于AI合成数据来训练Orion,并在后期训练中对模型进行更多改进。

目前,OpenAI正在推进Orion的安全测试,计划明年初发布该模型。它可能会打破“GPT-X”命名约定以反映模型开发的变化。

值得注意的是,OpenAI 今年收购了 Chat.com 域名,该域名重定向到 OpenAI 的人工智能聊天机器人 ChatGPT。

“撞上数据墙”

早在2020年,OpenAI就在论文中提出了Scaling law,这意味着大模型的最终性能主要与计算量、模型参数量、训练数据量有关,并且与模型的具体结构(层数/深度/宽度)基本上无关。换句话说,简单地增加模型大小和训练数据就可以显着提高人工智能能力,而无需实现根本性的算法突破。

AI行业的许多公司曾经将Scaling Law视为指导方针,但现在,越来越多的质疑浮现。

Meta AI人工智能研究院(FAIR)研究员、高级经理田元东指出,“我画了一张图,一开始的数据量越大,模型的性能越好,但模型越接近对于人类来说,获取新数据越困难,模型就越难以改进,最终总会出现无法解决的极端情况,这就是数据驱动的最大问题。”

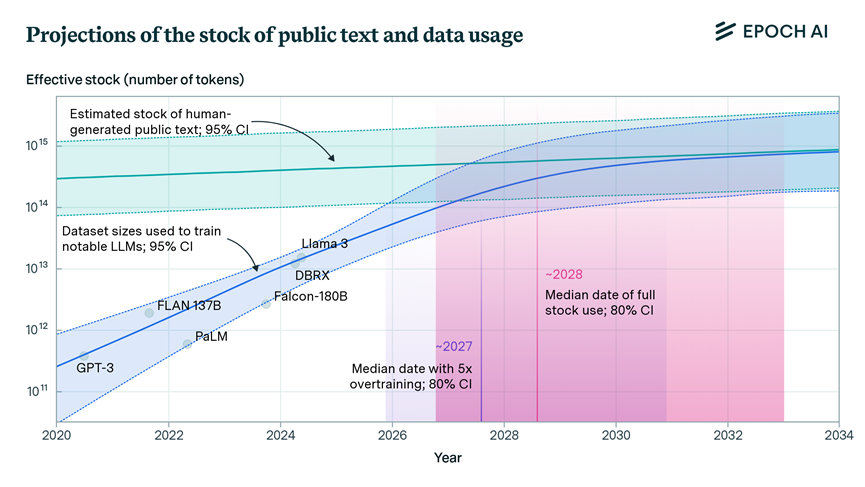

非营利研究组织Epoch AI在今年7月更新的论文中指出,未来几年,(原始)数据的增长速度将难以支撑大型AI模型的扩展和发展。 2026 年至 2032 年之间的某个时刻,数据库存将会耗尽。

事实上,这并不是OpenAI第一次遇到“数据资源不足”的问题。此前媒体报道指出,在训练 GPT-5 时,由于文本数据不足,OpenAI 正在考虑使用从 YouTube 公开视频转录的文本。

现在OpenAI再次遇到数据资源问题,甚至影响了新模型的进度。 “但这意味着‘天塌了’”,The Information 这篇文章的作者之一 Amir Efrati 指出,OpenAI 正在做出调整,或许新的 Scaling Law 将取代旧的 Scaling Law。

值得一提的是,当地时间11月9日,OpenAI安全系统团队负责人Lilian Weng宣布,在工作近7年后,他将离开OpenAI。她公开分享了发给团队的辞职信,但没有具体说明辞职的具体原因以及未来的职业方向。她只说“是时候重新开始,探索新的领域了”。

发表评论

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。