字节跳动回应实习生攻击大模型训练传闻:部分信息夸大失实

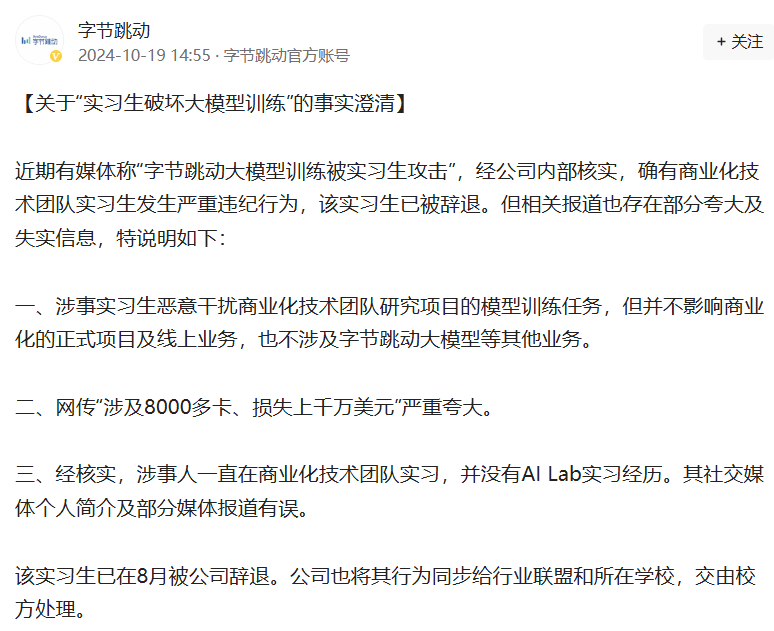

近日,有传言称字节跳动大模型训练遭到实习生攻击。对此,字节跳动于10月19日回应称,经公司内部核查,商业化技术团队一名实习生确实存在严重违纪行为,已被开除。但相关报道也存在一些夸大和不准确的信息。

字节跳动指出,涉事实习生恶意干扰商业化技术团队研究项目的模型训练任务,但并未影响正式商业化项目和线上业务,也没有涉及字节跳动大模型等其他业务。与此同时,网上有关“涉及8000多张卡、损失数千万美元”的报道也被严重夸大。

字节跳动还表示,经核实,涉事人员曾在商业化技术团队实习,没有AI Lab实习经历。他的社交媒体资料和一些媒体报道不正确。此外,该实习生于8月被公司解雇。该公司也将其行为向行业联盟和所在学校进行了举报,并交由学校处理。

10月18日,一则消息在多个微信群流传:“某领先厂商的大规模模型训练被实习生黑客攻击,注入破坏性代码,导致其训练结果不可靠,可能需要重新训练。”被泄露的代码被注入了 8000 多张卡中,造成的损失可能超过数千万美元。”

随后,有媒体报道称,他们从知情人士处获悉,主导厂商是字节跳动。这起事件发生在今年6月。起因是某大学的一名博士正在字节跳动商业化技术团队实习。由于对团队的资源分配不满意,他利用攻击代码破坏了团队的模型训练任务。

传闻称,实习生利用HF(huggingface)漏洞,在公司共享模型中编写破坏性代码,导致模型训练效果出现波动,无法产生预期的训练效果,AML团队无法验证原因。不过,谣言曝光后,该实习生也在微信群中辟谣,并表示自己在发表论文后就从字节跳动辞职。这时,另一个人利用漏洞更改了模型代码,并将责任归咎于自己。

大型模型的安全问题引起了业界的高度关注。今年8月,中国信息通信研究院发文表示,近年来,以大模型为核心的人工智能技术快速发展,成为数字经济增长的新动力。然而,大型模型作为一种新型生产力,在安全性方面仍然存在诸多缺陷,这给其大规模应用带来了不确定性。近日,中国信息通信研究院发布的大型模型安全基准AI Safety Benchmark的测试结果显示,恶意诱导方法下大型模型(尤其是开源大型模型)的攻击成功率与原始输入相比显着提高。因此,迫切需要安全地对齐大型模型。

发表评论

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。