DeepSeek-V3/R1推理系统揭秘:理论成本利润率高达545%,优化目标更大吞吐更低成本

让我们注意有关DeepSeek的最新消息!

DeepSeek首先披露:理论成本利润率545%

当市场认为DeepSeek的开源每周内容于3月1日发布时,DeepSeek宣布了“另一件事”,突然揭示了V3/R1推理系统,揭示了大规模部署的成本和收益。

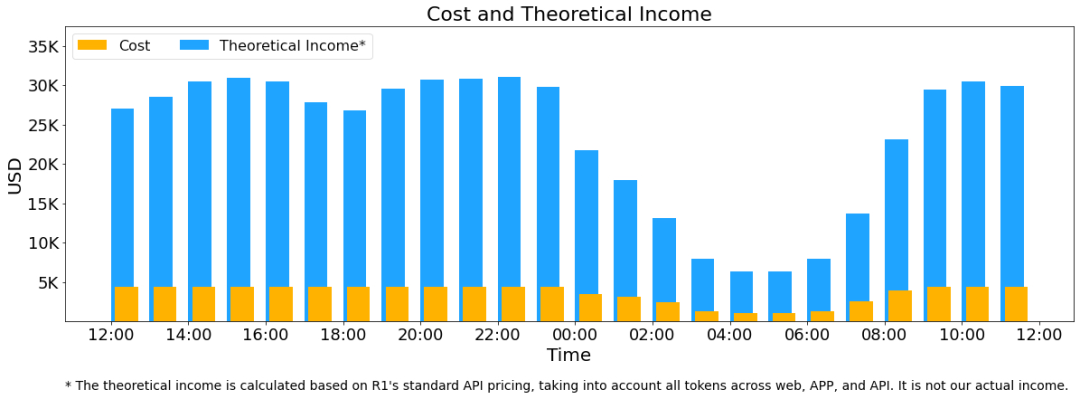

根据文章“ DeepSeek-V3/R1推理系统的概述”,假定GPU租金成本为2美元/小时,总成本为每天87,072美元;如果所有令牌是根据DeepSeek R1的定价计算的,则每天的理论总收入为每天562,027美元,成本利润率为545%。

根据官方披露,DeepSeek-V3/R1推理系统的优化目标是:更大的吞吐量和较低的延迟。

为了实现这两个目标,DeepSeek使用大规模的跨节点专家并行性(专家并行性/EP)。首先,EP大大增加了批量的大小,从而提高了GPU矩阵乘法的效率并改善了吞吐量。其次,EP分散了不同GPU的专家,每个GPU都需要计算较少的专家(因此内存提取要求更少),从而减少潜伏期。

但是EP也增加了系统的复杂性。复杂性主要反映在两个方面:

EP引入跨节点的传输。为了优化吞吐量,有必要设计适当的计算过程,以便可以同时执行传输和计算。

EP涉及多个节点,因此自然需要数据并行性(DP),并且在不同的DPS之间需要负载平衡。

因此,DeepSeek介绍了如何使用EP来增加批处理大小,如何隐藏耗时的变速箱以及如何加载平衡。

大规模跨节点专家并行性(专家并行性/EP)

由于DeepSeek-V3/R1的专家数量众多,因此只有8个在每层256位专家中被激活。该模型的高稀疏性确定必须使用较大的整体批量大小来为每个专家提供足够的专家批次大小,以实现更大的吞吐量和较低的延迟。需要大规模的跨节点专家并行性(专家并行性/EP)。

在多台和多张卡之间采用专家并行策略,以实现以下目标:

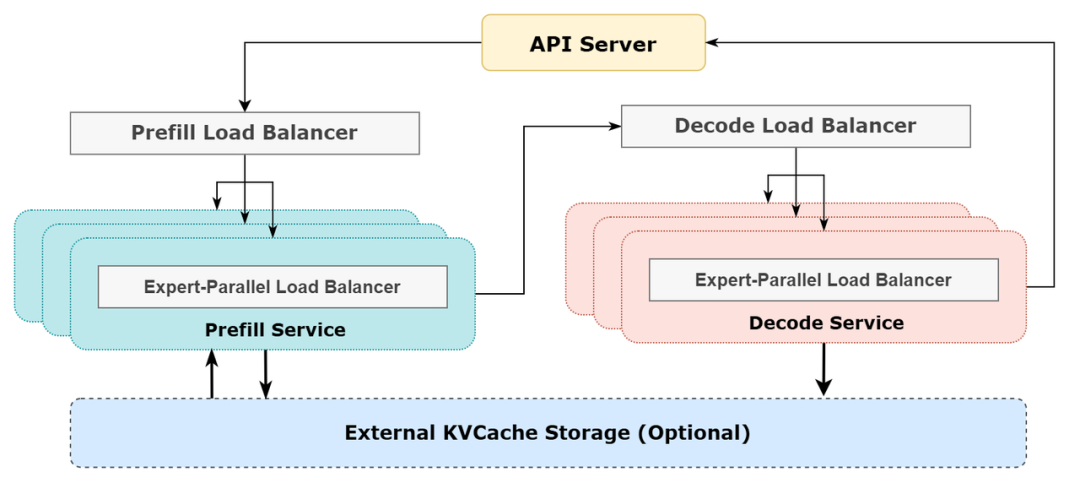

预填充:路由器专家EP32,MLA和共享专家DP32,部署单元是4个节点,32个冗余路由专家,9位路由专家和每张卡1个共享专家。

解码:路由器专家EP144,MLA和共享专家DP144,部署单元是18个节点,32个冗余路由专家,2位路由专家和每张卡的1个共享专家。

计算通信重叠

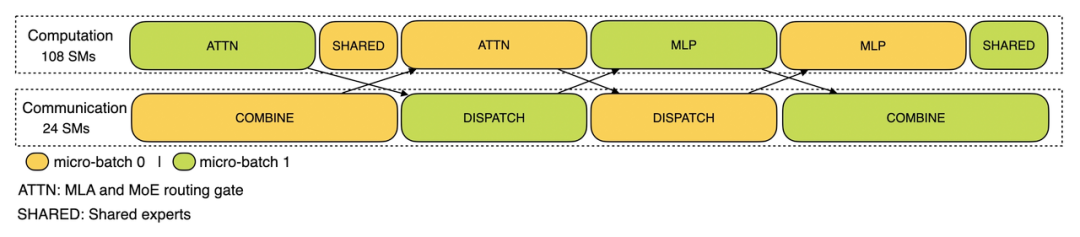

多台机器和多张卡的并行化将引入相对较大的通信开销,因此双批次重叠用于掩盖开销的交流并改善整体吞吐量。

对于预填充阶段,两批的计算和通信交错,一批可以在执行计算时覆盖另一批的通信开销。

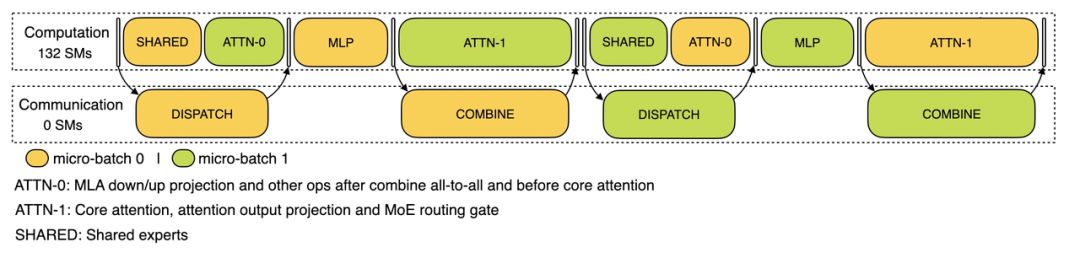

对于解码阶段,不同阶段的执行时间各不相同,因此注意力部分分为两个阶段,共有5个阶段管道以实现重叠的计算和通信。

尽可能多

由于采用了大规模的并行性(包括数据并行性和专家并行性),如果GPU的计算或通信负载太重,它将成为性能瓶颈并放慢整个系统;同时,其他GPU由于等待而闲置,导致整体利用率下降。因此,有必要尽可能将平衡的计算和通信负载分配给每个GPU。

预填充载客

核心问题:不同数据并行(DP)实例上请求的数量和长度不同,导致核心注意计算和调度传输不同。

优化目标:每个GPU的计算量应与核心注意计算负载平衡相同,并且输入令牌的数量应与调度传输负载平衡平衡相同,以免避免使用GPU的处理时间以避免太长。

解码器

核心问题:不同数据并行(DP)实例上请求的数量和长度不同,导致核心注意计算(与KVCACHE占有率有关)和调度传输。

优化目标:每个GPU的KVCACHE占有率应与相同的(核心注意计算负载平衡)相同,并且请求的数量应与相同(调度发送负载平衡)相同。

专家 - 帕利尔·阿德巴兰(Parallelloadbalancer)

核心问题:对于给定的MOE模型,有一些天然的高负载专家(专家),导致来自不同GPU的专家的计算负载不平衡。

优化目标:专家计算每个GPU上的幅度均衡(即最大程度地减少所有GPU的最大调度接收)。

在线系统的实际统计数据

DeepSeekv3和R1的所有服务都使用H800GPU,使用培训的一致精度,即,矩阵计算和调度传输采用一致的FP8格式,并具有一致的培训,以及核心注意计算和结合传输的BF16和一致的BF16和一致的培训,从而确保了最大程度的服务效果。

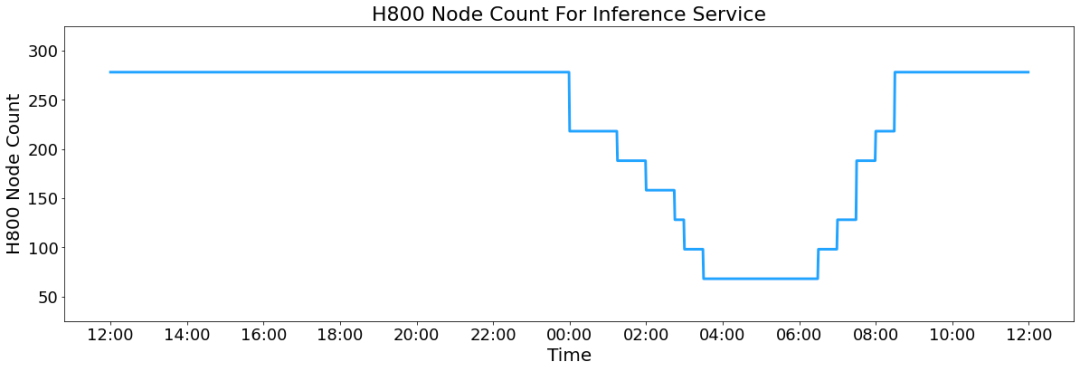

此外,由于白天的服务量高和晚上的服务负载较低,在白天的负载高时,实施了一种使用所有节点部署推理服务的机制。当晚上负载低时,减少用于研究和培训的推理节点。在过去的24小时中(北京时间2025/02/27 12:00至2025/02/28 12:00),DeepSeek-v3和R1推理服务占据了总节点,峰值占用率为278个节点,平均为226.75个节点(每个Node均为8 H800GPU)。假设GPU租金成本为每小时2美元,总成本为每天87,072美元。

在24小时的统计期内,DeepSeek-V3和R1:

输入令牌的总数为608b,其中342B令牌(56.3%)击中了KVCache硬盘驱动器缓存。

输出令牌的总数为168b。平均输出率为20〜22TPS,每个令牌输出的平均KVCACHE长度为4989。

每个H800的平均吞吐量为:对于预填充任务,输入吞吐量约为73.7ktokens/s(包括速度命中);对于解码任务,输出吞吐量约为14.8ktokens/s。

以上统计信息包括网页,应用程序和API的所有负载。如果所有令牌都是根据DeepSeek-R1的定价计算的,那么一天的理论总收入为562,027美元,成本利润率为545%。当然,实际上没有太多的收入,因为V3的价格较低,而付费服务仅在一部分时间内占用,并且晚上将有折扣。

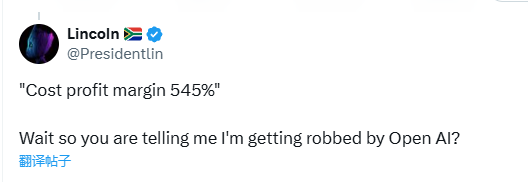

一些网民将DeepSeek与Openai进行了比较,并说:“'成本利润率为545%,等一下,所以您的意思是我被Openai抢劫了吗?”

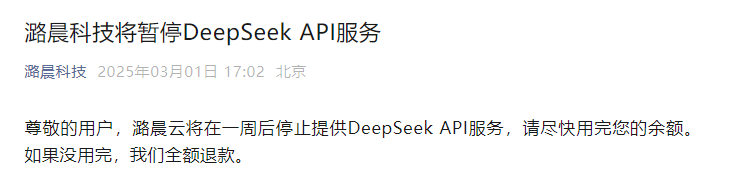

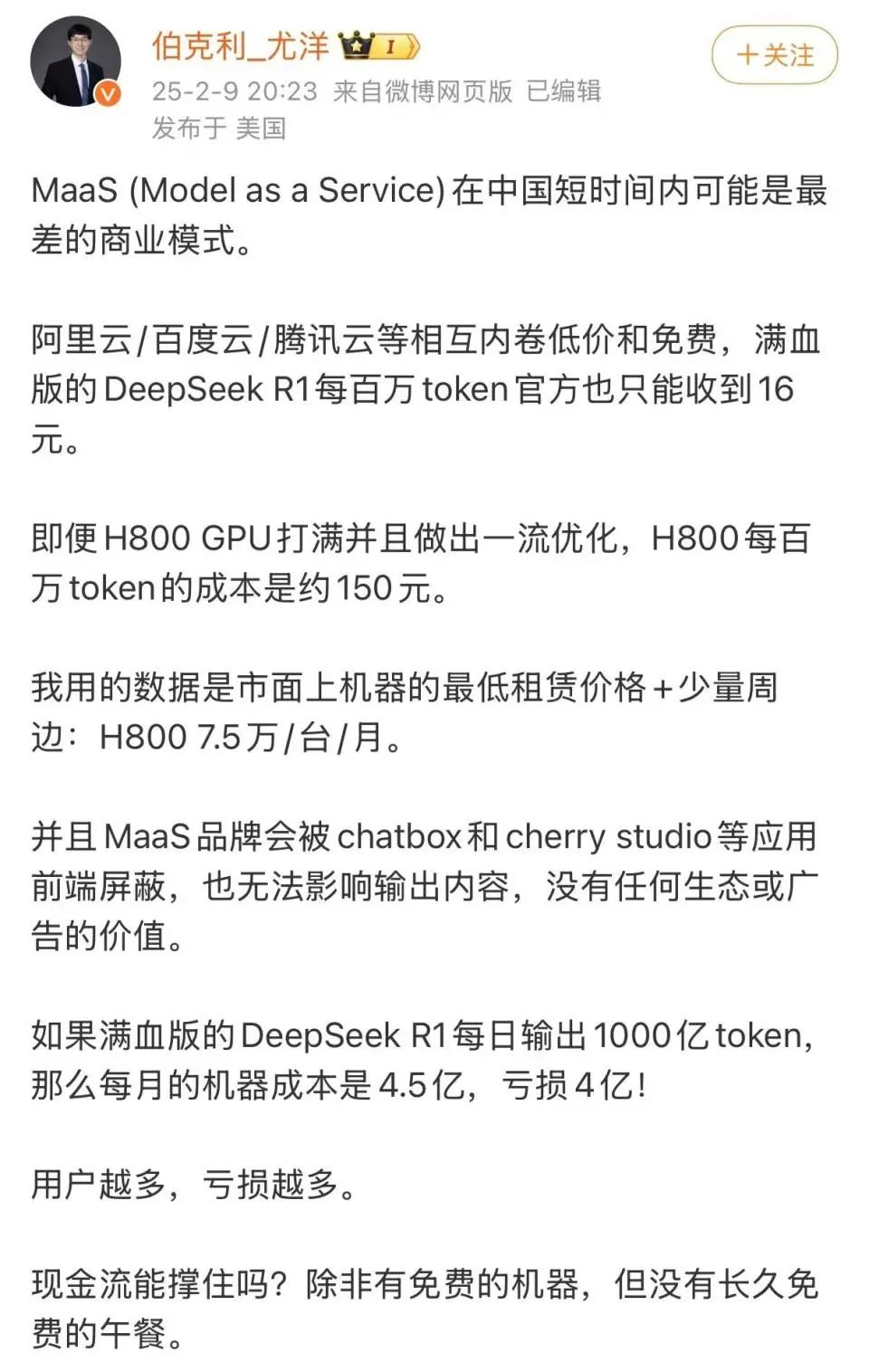

Luchen Technology暂停DeepSeek API服务

在DeepSeek透露了大规模部署的成本和收益之后,Luchen Technology突然宣布:“亲爱的用户,Luchen Cloud将在一周内停止提供DeepSeek API服务。请尽快使用您的余额。如果不用完,我们将全额退还。”

2月4日早些时候,华为计算计算电信公共帐户发表声明说,DeepSeek-R1系列模型的开源由于其出色的绩效和发展成本而引起了世界各地的热情讨论和关注。 Luchen Technology和Ascend共同发布了基于上升计算能力和云镜像服务的DeepSeek-R1推理API。

但是,最近,卢钦技术首席执行官Yang指出,DeepSeek-R1的全血版本的价格为16元百万元代币(输出)。如果每天产出1000亿个令牌,则该登记公司可以在一个月内赚取4,800万元人民币的收入。根据他的计算,大约需要4,000台配备H800的机器才能完成1000亿个令牌。根据当前的市场价格或H800的折旧,仅机器的月度成本将达到4.5亿元。因此,该公司每月可能面临4亿元人民币的每月损失,“用户越多,服务成本越高,损失越多。”

3月1日下午4点,Luchen Technology Youang发表声明,以回应DeepSeek宣布的理论成本利润率。

公共信息表明,Luchen技术是一家致力于“解放AI生产力”的全球企业。该团队的核心成员来自美国著名的国内和外国大学,例如加利福尼亚大学,伯克利大学,斯坦福大学,Tsinghua大学和美国的北京大学。主要业务包括分布式软件系统,大规模的人工智能平台和企业级云计算解决方案。该公司旨在建立一个开源的低成本AI大型模型开发系统,即Colossal-Ai,作为深度学习框架的核心,帮助企业最大程度地提高了人工智能培训的效率,同时最大程度地减少了人工智能培训的成本。

发表评论

◎欢迎参与讨论,请在这里发表您的看法、交流您的观点。